人工智慧(AI)已经开始改变我们生活的许多面向,创造了显著的社会进步。从自动驾驶汽车到AI辅助医疗诊断,都显示出我们正处于一个真正变革时代的开端。

然而,既然有了机会,挑战也随之而来。 AI推论是基于训练有素的机器学习演算法进行预测的过程,无论是部署在云端、边缘还是终端,都要求在严格的功率预算(power budget)下提供优异的处理效能。人们普遍认为,仅凭CPU难以满足这项要求,而是需要某种形式的运算加速才能更有效地处理AI推论的工作负载。

与此同时,AI演算法正快速发展,且比传统晶片的开发周期更迅速。如果使用ASIC等固定功能的晶片实现AI网路,则可能因先进AI模型的快速创新而很快就被淘汰。

整体应用加速

此外,还有第三个较鲜为人知的挑战,这项挑战来自于AI推论无法单独部署。真正的AI部署通常需要在AI功能之前和之后进行非AI处理;例如,图像可能需要完成解压缩和缩放后才能符合AI模型的资料输入要求。这些传统的处理功能必须在与AI功能相同的吞吐量(throughput)下运行,并且又要实现高效能与低功耗。与AI推论实现方案一样,非AI的前处理和后处理功能开始需要某种形式的加速。

仅加速AI是不够的

要建构真实的应用,就需要高效地执行整体应用。在资料中心应用中,该应用可能拥有数千个至数百万个并行执行个体(instance)。如果每个执行个体都能节省一定程度的功耗,总功耗将会有显著下降。

只有当「整体应用」能够透过加速满足其效能目标,同时又能藉由提高效率满足功耗要求时,这样的解决方案才具备可行性。那么,我们该如何透过可行的方式实现整体应用加速呢?

这里有三个关键因素:建立自订资料路径的能力、使用单一元件执行方案、随着最新AI模型的不断发展和演进而充分发挥它的优势。以下分别具体介绍这三个因素。

建立自订资料路径的能力

大部分的AI推论形式是在串流资料上运行。资料通常是动态的,例如影片的其中一部分、正在处理的医疗影像或是正在分析的网路流量。即使将资料储存在磁碟上,也要从磁碟上读取资料,并透过「AI应用」进行串流式传输。

自订资料路径为处理这类资料流提供了最有效的方法。自订资料路径让应用摆脱了传统的Von-Neuman CPU架构的限制。在这种架构中,资料以小批量从记忆体读取出,经过处理再写入回处理器。相反的,自订资料路径将资料从一个处理引擎传递给下一个处理引擎,不仅延迟时间短且效能适当。过低的处理效能无法满足这种应用的需求,而过高的处理效能则会降低效率,因?闲置功能会浪费功耗或物理空间。自订资料路径提供绝佳的平衡,为应用提供量身定制的执行方案。

单一元件执行方案

有些解决方案非常适合AI推论,但不擅长整体应用处理,如GPU等固定架构元件普遍不适合这类用途。 GPU往往能提供很高的TOP(Tera-operations per-second,一种常见的效能指标),但是AI推论效能通常需要与前处理效能和后处理效能匹配。如果非 AI 元件不能在同一个GPU上有效执行,就需要多元件解决方案。藉由要求在元件之间传递资料会浪费功耗,因此从功耗的角度来看其效率极低且成本高。因此,一个能够有效执行整体应用的单一元件在实际AI推论部署中拥有显著优势。

灵活适应最新的 AI 模型并随之演进

AI的创新速度令人叹为观止。如今被视为先进的AI技术,很可能在半年后就被宣告过时。而使用较旧模型的应用可能会面临丧失竞争力的风险,所以,能够快速执行最新模型的能力极为关键。

那么,什么样的技术既允许AI模型动态更新,又能提供建立自订资料路径的能力,从而在单一元件中加速AI和非AI处理呢?答案是:自行调适运算平台。

自行调适运算平台

自行调适运算平台基于能在制造后动态重配置的硬体上,这包括FPGA等经过长期检验的技术,以及赛灵思AI引擎等先进的创新。赛灵思Versal自行调适运算加速平台等单元件平台便于建立自订资料路径,加速AI处理和非AI处理功能。此外,因为硬体可以快速重新配置,所以它们也能迅速且有效地执行最新AI模型。自行调适运算元件提供了两全其美的优势,既具备自订ASIC的效率优势,而无需漫长且高成本的设计周期。

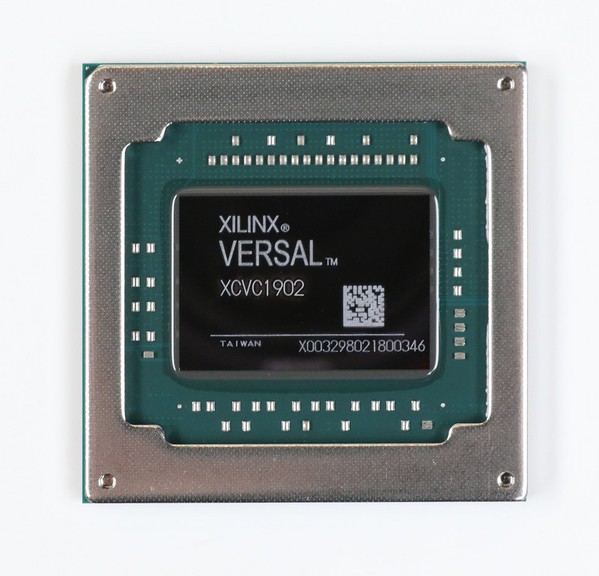

| 图二 : 赛灵思Versal AI Core系列 VC1902 |

|

最优秀的AI应用执行方案未必是速度最快的。它需要的是在最高效率下,同时保持灵活性。它必须是量身定制且不多不少地提供所需的效能。

总结

随着AI推论的应用日益普及,其挑战不仅在于如何部署AI模型,也在于如何最有效地部署整体AI应用。在应用被复制数千次乃至数百万次时,每个执行个体的少量节能也许能省下整个发电站所需的能源。如果将这种节能扩展到中不计其数开发中的新AI应用中,效果将非常显著。毫无疑问,整体AI应用的有效加速应成为技术产业所有业者的目标,而自行调适运算平台则提供了极具竞争力的解决方案。

(本文作者Greg Martin为赛灵思策略行销总监)