大型语言模型提供极为出色的新功能,扩大人工智慧潜在的应用领域。不过其庞大规模与独特的执行特性,很难用具成本效益的方式来使用它们。

|

| NVIDIA TensorRT-LLM增强了 NVIDIA H100 GPU 上大型语言模型的推论能力 |

NVIDIA 不断与 Meta、AnyScale、Cohere、Deci、Grammarly、Mistral AI、MosaicML(现已成为 Databricks 的一员)、OctoML、Tabnine及Together AI等重点企业密切合作,以加快大型语言模型的推论速度及取得最隹的推论结果。

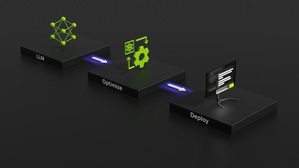

这些创新项目已经整合进开源型态的 NVIDIA TensorRT-LLM 软体,将在未来几周内发布。TensorRT-LLM 由 TensorRT 深度学习编译器组成,包括经最隹化调整的内核、前处理和後处理步骤,以及多GPU/多节点通讯基元,可在 NVIDIA GPU 上创造出突破性的效能表现。它让开发人员能够尝试新的大型语言模型,提供峰值效能和快速自订功能,而无需具备深厚的 C++ 或 NVIDIA CUDA 相关知识。

TensorRT-LLM 透过开源模组 Python API,提高了易用性和扩充性,可用於定义、最隹化和执行新架构,还会随着大型语言模型的发展而增强,且能轻松自订相关内容。

例如 MosaicML 在 TensorRT-LLM 的基础上无缝增加所需的特定功能,并将其整合到推论服务中。Databricks 工程部门??总裁 Naveen Rao 指出:「这绝对是一件轻而易举的事。」

「TensorRT-LLM 简单易用,提供包括词元串流处理(streaming of tokens)、动态批次处理(in-flight batching)、paged-attention、量化等齐全的功能,而且效率出色。它为使用 NVIDIA GPU 的大型语言模型服务提供了最先进的效能,让我们能够把省下来的成本回??给客户。」Rao 说。

大型语言模型生态系统呈现爆炸性发展

生态系统正在快速创新,发展出全新多样化的模型架构。更大的模型释放出新的功能和使用范例。像是 Meta 旗下拥有 700 亿个叁数的 Llama 2,这一类最大、最先进的语言模型需要多个 GPU 协同工作,才能即时提供回应。开发人员过去如果想获得最隹的大型语言模型推论表现,就必须重写和手动将人工智慧模型分割成多个片段,然後跨多个 GPU 协调执行。

TensorRT-LLM 使用一种模型平行化(model parallelism)的 tensor 平行,将个别权重矩阵分割到各个装置上。如此一来便能以大规模高效率的方式进行推论 - 可以在透过 NVLink 连接的多个 GPU 和多个伺服器上平行运作每个模型,无需开发人员出手干预或修改模型。

随着推出新模型和模型架构,开发人员可以利用 TensorRT-LLM 中开源型态的最新 NVIDIA 人工智慧内核,将其模型调整至最隹状态。支援的内核融合包括尖端的FlashAttention 和 Masked Multi-Head Attention技术,用於GPT模型执行的上下文和生成阶段,以及许多其他功能。

此外,TensorRT-LLM 还包括当今生产环境中已广泛使用的许多大型语言模型的完全最隹化、可立即运行版本。其中包括 Meta Llama 2、OpenAI GPT-2 和 GPT-3、Falcon、Mosaic MPT、BLOOM 及其他十几种,都能透过简单易用的 TensorRT-LLM Python API 来操作这些大型语言模型。

这些功能可帮助开发人员更快、更准确地开发自订的大型语言模型,以满足几??各行各业的需求。

动态批次处理

当今的大型语言模型极为多样化。一个模型可同时用於处理多种彼此间差异极大的任务。从聊天机器人中简单的一问一答,到文件摘要或生成长篇程式码,要用高度动态的方式来处理这些工作,而输出的大小则是天差地远。

这种多功能性可能会导致难以有效地批量处理请求并行执行它们(而这是用於服务神经网路时常见的最隹化方式),造成某些请求比其他请求更早完成。

为了管理这些动态负载,TensorRT-LLM 包含了一种称为动态批次处理(in-flight batching)_的最隹调度技术。这项技术让一个大型语言模型的整体文字生成过程可拆分成在模型上执行的多次迭代。

TensorRT-LLM 利用动态批次处理技术,不会等到整个批次处理完成後再处理下一组请求,而是会立即从批次处理中移除已经完成的序列。在其他请求仍被处理中,它就开始执行新的请求。动态批次处理与额外的内核级最隹化技术提高了 GPU 的使用率,将 H100 Tensor 核心 GPU 上实际 LLM 请求基准的吞吐量最少提高了一倍,有助於渐少能耗以及将总持有成本降至最低。

H100 Transformer 引擎加上 FP8

大型语言模型内有数十亿个模型权重和启动项目,通常使用 16 位元浮点(FP16 或 BF16)值进行训练和表示,每个值占用 16 位元记忆体。然而,在推论过程中,大多数模型可以使用现代量化技术有效地表示为较低精度,如8位甚至4位整数(INT8或INT4)。

量化是在不失准确度的前提下,降低模型权重和启动精度的过程。使用更低精度代表每个叁数更小,模型占用 GPU 记忆体的空间也更小。这样就能在相同硬体条件下对更大的模型进行推论,同时在执行过程中减少记忆体运作时间。

NVIDIA H100 GPU 加上 TensorRT-LLM,让使用者能够轻松将模型权重转换为新的 FP8 格式,并自动编译模型以利用最隹化的 FP8 内核。在 Hopper Transformer 引擎 技术实现的,无需更动任何模型程式码。

H100 引入的 FP8 资料格式使得开发人员能够量化他们的模型,并在不降低模型准确度的情况下大幅减少记忆体消耗。与 INT8 或 INT4 等其他资料格式相比,FP8 量化保留了更高的准确度,同时做到最快的效能表现和最简单的实现。

结语

大型语言模型的发展日新月异。每天都开发出不同的模型架构,促进生态系统不断发展。而大型模型也会释放出新的功能和使用范例,推动各产业加以采用。

大型语言模型推论技术为资料中心打开新的局面。更出色的效能及更高的准确性为企业降低了总持有成本。模型创新能够创造出更美好的客户体验,进而带来更高的收入和收益。

在规划推论部署项目之际,要利用最先进的 LLM 达到最隹效能,仍要考虑许多其他因素。最隹化这件事很少会自动进行。使用者必须考虑平行、端到端工作流程和先进调度技术等微调模型的因素。他们还要有一个能够处理混合精度,又不会降低准确度的运算平台。

TensorRT-LLM 包括 TensorRT 的深度学习编译器、最隹化的内核、前处理和後处理,以及在一个简单的、开源的Python API中实现多GPU/多节点通讯,用於定义、最隹化和执行大型语言模型,以进行生产环境中的推论。